Содержание

- 1 Недостатки встроенной графики

- 2 Программирование GPU на Java

- 3 Посторонись, CUDA — Intel анонсировала 7-нанометровый GPU для дата-центров

- 4 Эпоха GPU

- 5 Встроенный GPU

- 6 Виды графических процессоров

- 7 GPU что это в компьютере?

- 8 Скорость глубокого обучения GPU в пересчёте на стоимость

- 9 NVIDIA GPU и сравнение GPU и CPU

- 10 Зачем и где используется GPU

- 11 Питание для GPU

- 12 Что такое CPU?

- 13 Что такое GPU

- 14 Аппаратные компоненты бортовой МПС унифицированного ударного истребителя F-35

- 15 Что такое GPU-ускорение на Android

- 16 Температура GPU

- 17 Словарь

- 18 Вариант для офисных задач и домашнего использования

- 19 Выводы

Недостатки встроенной графики

Поскольку разобрались с плюсами, нужно проработать и недостатки решения.

Главный минус подобной затеи – производительность. Да, вы можете с чистой совестью играть в более-менее современные игрушки на низких и высоких настройках, однако любителям графики, такая затея точно не придется по вкусу. Ну а если вы работаете с графикой профессионально (обработка, рендеринг, монтаж видеороликов, постпродакшн), да еще и на 2–3 мониторах, то интегрированный тип видео вам точно не подойдет.

- Момент номер 2: отсутствие собственной скоростной памяти (в современных картах это GDDR5, GDDR5X и HBM). Формально видеочип может использовать хоть до 64 ГБ памяти, однако вся она будет браться откуда? Правильно, из оперативной. А значит необходимо заранее построить систему таким образом, чтобы ОЗУ хватило и для работы, и для графических задач. Учитывайте, что скорость современных DDR4-модулей значительно ниже, нежели GDDR5, а потому времени на обработку данных будет тратиться больше.

- Следующий недостаток – тепловыделение. Помимо собственных ядер на процессе появляется еще одно, которое, в теории, прогревается ничуть не меньше. Охлаждать все это великолепие боксовой (комплектной) вертушкой можно, но готовьтесь к периодическим занижениям частот в особо сложных расчетах. Покупка более мощного кулера решает проблему.

- Ну и последний нюанс – невозможность апгрейда видео без замены процессора. Иными словами, чтобы улучшить встроенное видеоядро, вам придется в буквальном смысле покупать новый процессор. Сомнительная выгода, не так ли? В таком случае проще через некоторое время приобрести дискретный ускоритель. Производители вроде AMD и nVidia предлагают отличные решения на любой вкус.

Программирование GPU на Java

- Перевод

Получение доступа к GPU из Java раскрывает огромную мощь. Здесь рассказывается как GPU работает и как получить доступ из Java.

Программирование устройства графического процессора (GPU) является заоблачным миром для Java программистов. Это понятно, так как обычные задачи для Java не подходят для GPU. Тем не менее, GPU обладают терафлопсами производительности, так давайте исследуем их возможности.

Для того чтобы сделать топик доступным, я потрачу некоторое время объясняя архитектуру GPU вместе с небольшой историей, которая облегчит погружение в программирование железа.

Однажды мне показали отличия GPU от CPU вычислений, я покажу как использовать GPU в мире Java. Наконец, я опишу главные фреймворки и библиотеки доступные для написания кода на Java и запуска их на GPU, и я приведу некоторые примеры кода.

Посторонись, CUDA — Intel анонсировала 7-нанометровый GPU для дата-центров

По прогнозам аналитиков, рынок дата-центров в ближайшие годы будет расти на 38% в год и за пять лет вырастет до $35 млрд, а самая ресурсоёмкая ниша (по интенсивности вычислений) — глубокое обучение, нейросети и задачи AI.

Конечно, Intel не собирается равнодушно смотреть, как Nvidia (и AMD, в меньшей степени) со своими GPU захватывают этот рынок, включая самый быстрорастущий сектор. На прошлой неделе гигант микроэлектронной промышленности сделал сразу несколько громких анонсов:

- процессоры для нейросетей Nervana NNP-T1000 и NNP-I1000 (NNP: neural network processors), а также чип Movidius VPU;

- 10-нанометровые процессоры Xeon Scalable (кодовое название Sapphire Rapids);

- унифицированные программные интерфейсы oneAPI (для CPU, GPU, FPGA) — конкурента Nvidia CUDA;

- 7-нанометровый GPU для дата-центров с кодовым названием Ponte Vecchio на новой архитектуре Xe.

Эпоха GPU

Для начала вспомним, что же такое GPU. Graphics Processing Unit — это графический процессор широко используемый в настольных и серверных системах. Отличительной особенностью этого устройства является ориентированность на массовые параллельные вычисления. В отличие от графических процессоров архитектура другого вычислительного модуля CPU (Central Processor Unit) предназначена для последовательной обработки данных. Если количество ядер в обычном CPU измеряется десятками, то в GPU их счет идет на тысячи, что накладывает ограничения на типы выполняемых команд, однако обеспечивает высокую вычислительную производительность в задачах, включающих параллелизм.

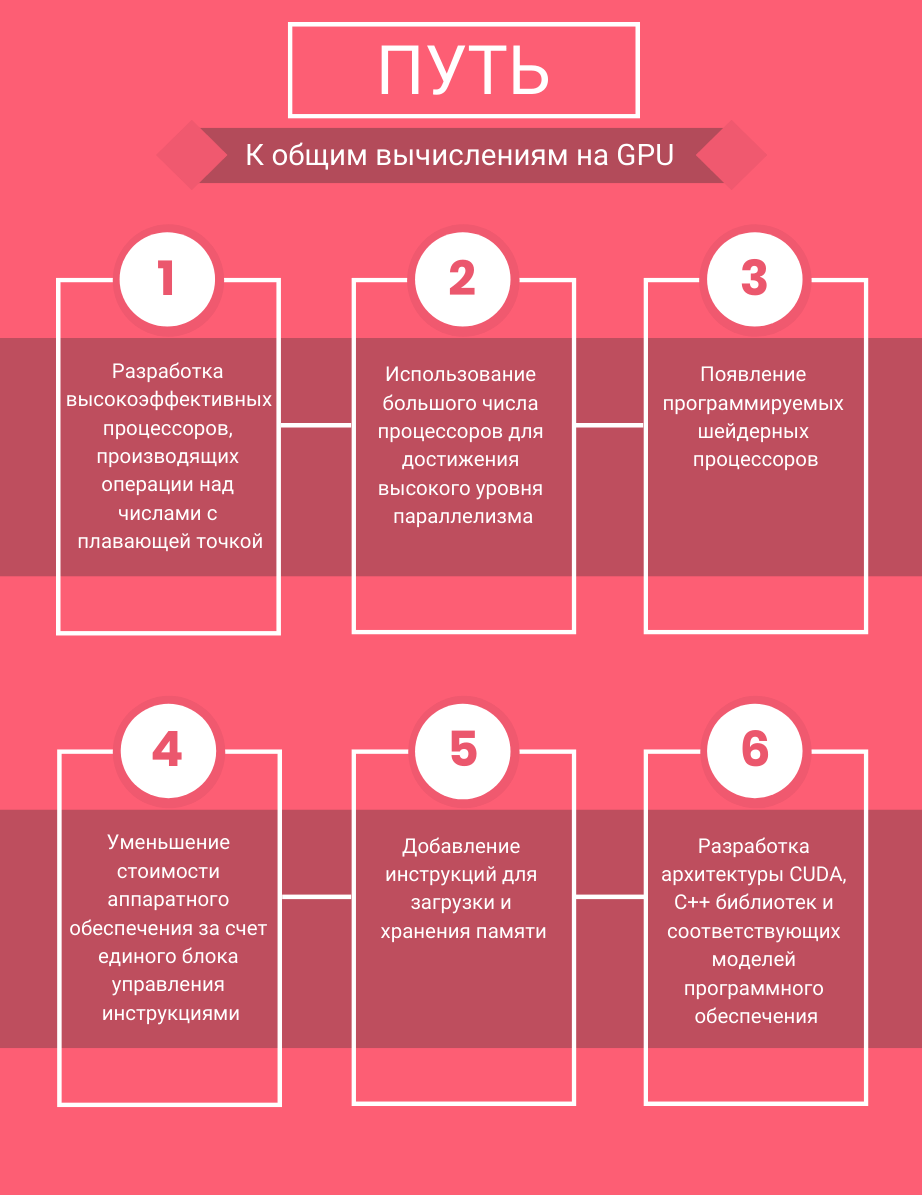

Первые шаги

Развитие видеопроцессоров на ранних этапах было тесно связано с нарастающей потребностью в отдельном вычислительном устройстве для обработки двух и трехмерной графики. До появления отдельных схем видеоконтроллеров в 70-х годах вывод изображения осуществлялся через использование дискретной логики, что сказывалось на увеличенном энергопотреблении и больших размерах печатных плат. Специализированные микросхемы позволили выделить разработку устройств, предназначенных для работы с графикой, в отдельное направление.

Следующим революционным событием стало появление нового класса более сложных и многофункциональных устройств — видеопроцессоров. В 1996 году компания 3dfx Interactive выпустила чипсет Voodoo Graphics, который быстро занял 85% рынка специализированных видеоустройств и стал лидером в области 3D графики того времени. После серии неудачных решений менеджмента компании, среди которых была покупка производителя видеокарт STB, 3dfx уступила первенство NVIDIA и ATI (позднее AMD), а в 2002 объявила о своем банкротстве.

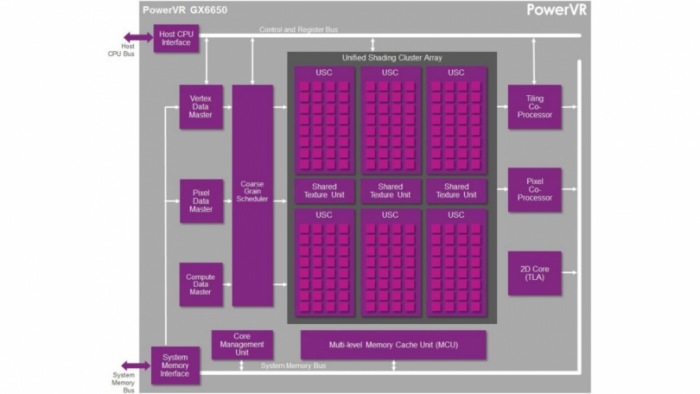

Общие вычисления на GPU

В 2006 году NVIDIA объявила о выпуске линейки продуктов GeForce 8 series, которая положила начало новому классу устройств, предназначенных для общих вычислений на графических процессорах (GPGPU). В ходе разработки NVIDIA пришла к пониманию, что большее число ядер, работающих на меньшей частоте, более эффективны для параллельных нагрузок, чем малое число более производительных ядер. Видеопроцессоры нового поколения обеспечили поддержку параллельных вычислений не только для обработки видеопотоков, но также для проблем, связанных с машинным обучением, линейной алгеброй, статистикой и другими научными или коммерческими задачами.

Признанный лидер

Различия в изначальной постановке задач перед CPU и GPU привели к значительным расхождениям в архитектуре устройств — высокая частота против многоядерности. Для графических процессоров это заложило вычислительный потенциал, который в полной мере реализуется в настоящее время. Видеопроцессоры с внушительным количеством более слабых вычислительных ядер отлично справляются с параллельными вычислениями. Центральный же процессор, исторически спроектированный для работы с последовательными задачами, остается лучшим в своей области.

Для примера сравним значения в производительности центрального и графического процессора на выполнении распространенной задачи в нейронных сетях — перемножении матриц высокого порядка. Выберем следующие устройства для тестирования:

- CPU. Intel Xeon E5-2680 v4 — 28 потоков с HyperThreading, 2.4 GHZ;

- GPU. NVIDIA GTX 1080 — 2560 CUDA Cores, 1607 Mhz, 8GB GDDR5X.

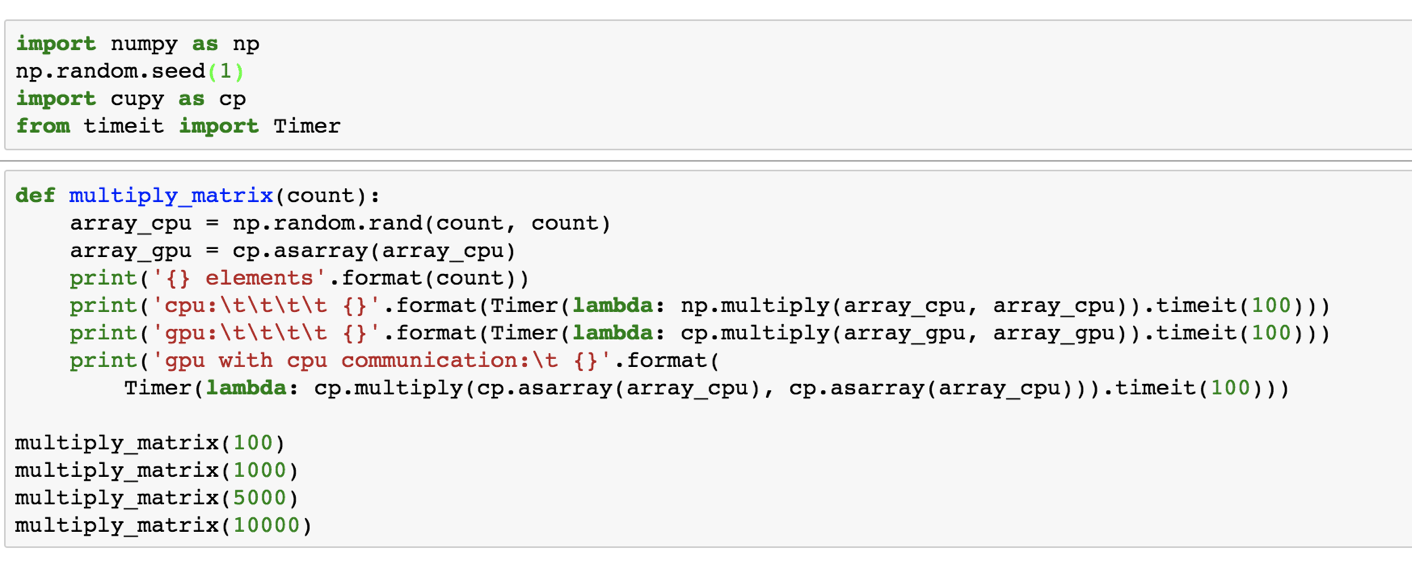

Используем пример вычисления перемножения матриц на CPU и GPU в Jupyter Notebook:

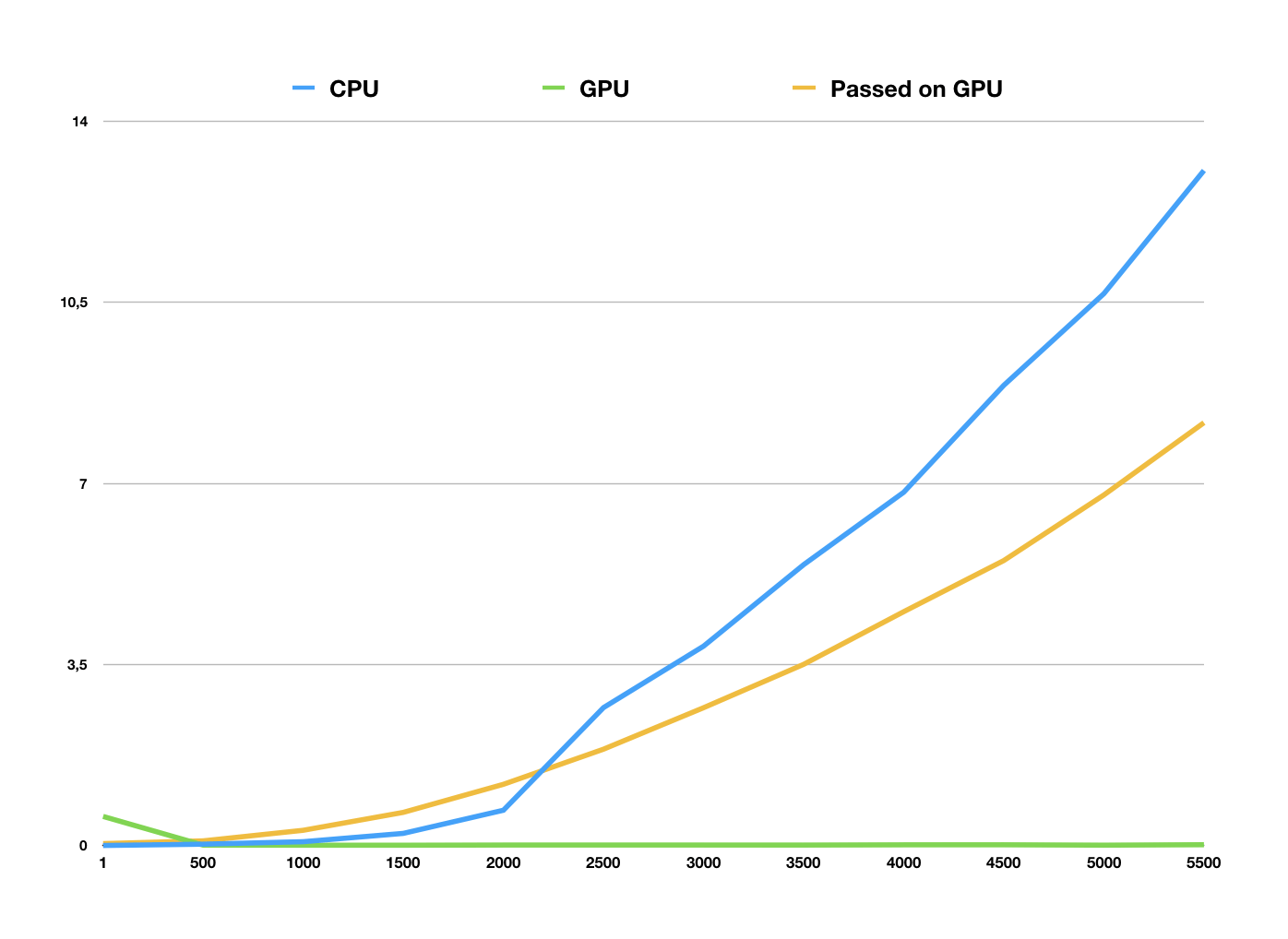

В коде выше мы измеряем время, которое потребовалось на вычисление матриц одинакового порядка на центральном или графическом процессоре («Время выполнения»). Данные можно представить в виде графика, на котором горизонтальная ось отображает порядок перемножаемых матриц, а вертикальная — Время выполнения в секундах:

Линия графика, выделенная оранжевым, показывает время, которое требуется для создания данных в обычном ОЗУ, передачу их в память GPU и последующие вычисления. Зеленая линия показывает время, которое требуется на вычисление данных, которые были сгенерированы уже в памяти видеокарты (без передачи из ОЗУ). Синяя отображает время подсчета на центральном процессоре. Матрицы порядка менее 1000 элементов перемножаются на GPU и CPU почти за одинаковое время. Разница в производительности хорошо проявляется с матрицами размерами более 2000 на 2000, когда время вычислений на CPU подскакивает до 1 секунды, а GPU остается близким к нулю.

Более сложные и практические задачи эффективнее решаются на устройстве с графическими процессорами, чем без них. Поскольку проблемы, которые решают наши клиенты на оборудовании с GPU, очень разнообразны, мы решили выяснить, какие самые популярные сценарии использования существуют.

Встроенный GPU

Интегрированная видеокарта располагается на материнской плате или в процессоре. То, что это GPU в компьютере, не означает, что надо запускать требовательные игры или фильмы в высоком качестве. Дело в том, что видеокарты данного типа рассчитаны на работу с простыми приложениями, которые не требуют больших ресурсов. К тому же они не потребляют большое количество энергии.

Что касается объема памяти, то интегрированное GPU в компьютере использует для работы объем и частоты оперативной памяти.

Большинство пользователей используют карты данного типа только для того, чтобы установить драйвера на дискретную видеокарту.

Виды графических процессоров

Существует не так много видов графических процессоров, один из них именуется, как дискретный, и применяется на отдельных модулях. Такой чип достаточно мощный, поэтому для него требуется система охлаждения из радиаторов, кулеров, в особо нагруженных системах может применяться жидкостное охлаждение.

Сегодня мы можем наблюдать значительный шаг в развитие графических компонентов, это обуславливается появлением большого количества видов GPU. Если раньше любой компьютер приходилось снабжать дискретной графикой, чтобы иметь доступ к играм или другим графическим приложениям, то сейчас такую задачу может выполнять IGP — интегрированный графический процессор.

Интегрированной графикой сейчас снабжают практически каждый компьютер (за исключением серверов), будь то, ноутбук или настольный компьютер. Сам видео-процессор встроен в CPU, что позволяет значительно снизить энергопотребление и саму цену устройства. Кроме того, такая графика может быть и в других подвидах, например: дискретная или гибридно-дискретная.

Первый вариант подразумевает наиболее дорогое решение, распайку на материнской плате или же отдельный мобильный модуль. Второй вариант называется гибридным неспроста, фактически он использует видеопамять небольшого размера, которая распаяна на плате, но при этом способен расширять её за счёт оперативной памяти.

Естественно, такие графические решения не могут поравняться с полноценными дискретными видеокартами, но уже сейчас показывает достаточно хорошие показатели. В любом случае, разработчикам есть куда стремиться, возможно за таким решением будущее.

Ну а на этом у меня, пожалуй, все. Надеюсь, что статья вам понравилась! Жду вас снова у себя на блоге в гостях. Удачи вам. Пока-пока!

GPU что это в компьютере?

Всем привет GPU это обозначение видеокарты, если быть точнее то графический процессор. Данное слово, ну то есть аббревиатуру часто можно встретить в каких-то характеристиках, ну вот например в характеристиках процессора Intel есть такое понятие как Integrated GPU, что означает встроенная видеокарта. Ну все верно, она реально встроена, видео чип сидит прямо в процессоре, это не новость как бы

То есть вывод мы уже сделали, GPU это видюха

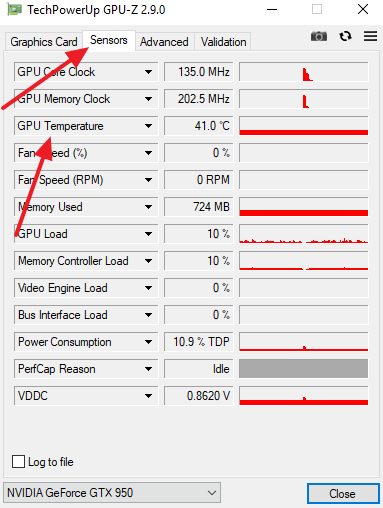

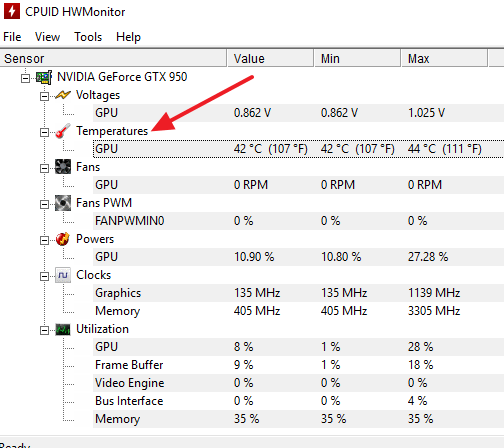

Но что еще важно понимать? Я вот писал, что GPU встречается в характеристиках, все верно, по помимо этого также можно встретить и в программах, которые показывают температуру. Я думаю что вы такие проги знаете.

Ну или не знаете, короче в любом случае, то что я сейчас напишу, то это вам будет полезно знать. Значит речь идет про температуру GPU. Многие уверяют, что видюха может работать и при 80 градусах, а вот я заявляю что это слишком высокая температура! Да и вообще я считаю что выше 70 это не норма!

Кстати GPU расшифровывается как Graphics Processing Unit

А вот и сам графический чип, ну то есть GPU, вот я его стрелочками указал на плате:

Но какая тогда норм температура? До 60 градусов, ну максимум 66, ну 70 градусов это уже потолок… Но выше я думаю что это уже не оч хорошо, просто срок службы точно не продлит такая температура, согласны со мной? Ну и еще есть интересный момент, короче если видюха прилично греется, то блин она еще и выкидывает свое тепло в корпус, ну в нем явно не будет прохладно, а тут и процессу станет жарко, короче веселуха! Помните, что именно ТЕМПЕРАТУРА способна снизить срок работы устройства! Вот на старых материнках от высокой температуры взрывались электролитические конденсаторы.. Если не верите, то можете сами посмотреть в интернете..

Ну вот скажите мне, вам тут все было понятно? Честно, буду надеяться что да! Ну а если что не так, ну так уж извините!

Скорость глубокого обучения GPU в пересчёте на стоимость

- Использование предварительно обученных трансформеров, или обучение небольшого трансформера с нуля >= 11 ГБ.

- Обучение большого трансформера или свёрточной сети в исследовании или продакшене: >= 24 ГБ.

- Прототипирование нейросетей (трансформера или свёрточной сети) >= 10 ГБ.

- Участие в конкурсах Kaggle >= 8 ГБ.

- Компьютерное зрение >= 10 ГБ.

Рис. 3: нормализованное быстродействие в пересчёте на доллары по отношению к RTX 3080.Рис. 4: нормализованное быстродействие в пересчёте на доллары по отношению к RTX 3080.Рис. 5: нормализованное быстродействие в пересчёте на доллары по отношению к RTX 3080.

NVIDIA GPU и сравнение GPU и CPU

Облачные вычисления кардинально изменили все отрасли промышленности, демократизировав дата-центры и полностью изменив принципы работы предприятий. Самые важные активы компании теперь хранятся в облаке выбранного вами провайдера. Однако, чтобы извлечь максимальную пользу из имеющихся данных, требуется подходящее высокопроизводительное вычислительное решение.

ПО NVIDIA Deep Learning создано для обеспечения максимальной производительности на самых быстрых в мире GPU и содержит оптимизированные фреймворки глубокого обучения, библиотеки, драйверы и ОС.Это унифицированное ПО работает на различных вычислительных платформах, начиная от видеокарт TITAN X и GeForce GTX 1080Ti и заканчивая системами DGX и облаком, и доступно круглосуточно.

Облачные вычисления на GPU также доступны по запросу на всех основных облачных платформах.

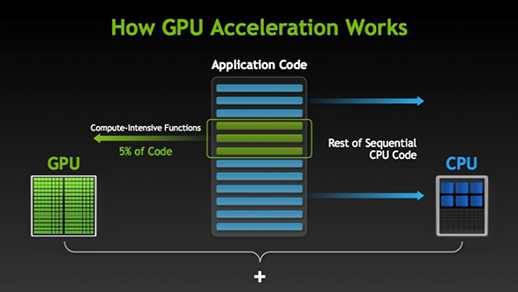

КАК ПРИЛОЖЕНИЯ ПОЛУЧАЮТ УСКОРЕНИЕ НА GPU

GPU обрабатывает части приложения, требующие большой вычислительной мощности, при этом остальная часть приложения выполняется на CPU. С точки зрения пользователя, приложение просто работает значительно быстрее.

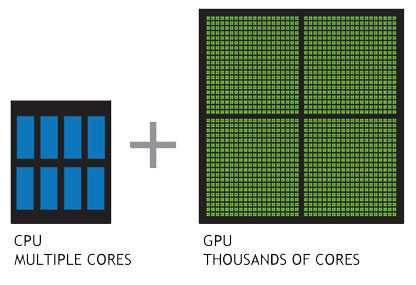

Простой способ понять разницу между GPU и CPU — сравнить то, как они выполняют задачи. CPU состоит из нескольких ядер, оптимизированных для последовательной обработки данных, в то время как GPU имеет тысячи более мелких и энергоэффективных ядер, созданных для выполнения нескольких задач одновременно.

GPU состоит из тысячи ядер для эффективной обработки параллельных задач

Посмотрите видеоролик ниже, что сравнить GPU и CPU

Более 400 приложений,—включая 9 из 10 ведущих HPC-приложений, уже получили ускорение на GPU, благодаря чему все пользователи графических процессоров могут добиться значительно повышения производительности для своих задач. Посмотрите в нашем каталоге приложений, имеет ли приложение, с которым вы работаете, GPU ускорение (PDF 1,9 MБ).

- Использовать GPU-оптимизированные библиотеки

- Добавить директивы или «подсказки» компилятору для автоматического распараллеливания вашего кода

- Использовать расширения для языков программирования, которые вы уже знаете, например, C и Fortran

Узнать, как использовать GPU с моделью параллельного программирования CUDA, очень легко.

Бесплатные онлайн занятия и ресурсы для разработчиков доступны на CUDA Zone.

ЗАЙДИТЕ НА CUDA ZONE

Зачем и где используется GPU

Первое, что приходит на ум для юзера, который хотя бы немного знаком с компьютерами — видеоигры. Это действительно так: киберспорт — отрасль, где графические адаптеры используются по максимуму. Сегодня сложно представить «серьезную» игру, которая реализована не в 3D.

Однако видеоигры — не единственная отрасль, где нужен GPU. Вспомните недавний хайп по поводу майнинга криптовалют, в частности биткоина, и последующее массовое появление на вторичном рынке графических адаптеров, ранее используемых для майнинга.

Также графический адаптер используется для обработки любого изображения — будь то просмотр видео на Ютубе или редактирование фотографий в «Фотошопе». Соответственно, если мощности GPU недостаточно, с запуском «прожорливых» в плане вычислительной мощности приложений могут быть проблемы.

Также для вас полезно будет почитать «Что такое технология CUDA в видеокартах Nvidia?» и «Что означает Dual в маркировки видеокарты и что это дает покупателю». Все про пропускную способность видеокарты можно узнать в этом посте.

Питание для GPU

Встроенные графические процессоры не нуждаются в дополнительном питании, однако дискретные представители требуют более мощного блока питания. Офисные видеокарты будут нормально функционировать и с блоком в 450 ватт. Для съемных графических ускорителей потребуется блок питания более 500 ватт. При грамотном его подборе можно полностью раскрыть потенциал видеокарты. Тем более что система охлаждения дискретной видеокарты будет лучше функционировать при достаточном количестве электроэнергии.

Питание играет немаловажную роль. Без процессора графического ускорения невозможно вывести изображение на экран. Чтобы увидеть, как отображается видеокарта в системе, достаточно зайти в панель управления и открыть вкладку «Видеоадаптеры». Если отображается надпись «Устройство не опознано», то необходимо установить драйвера для своего графического процессора. После установки драйверов модель карты будет корректно отображаться в системе.

Привет, друзья.

Вы любите поиграть в реалистичные игры на компе? Или посмотреть фильм в качестве, при котором четко видно каждую мелочь? Значит, вы должны представлять, что такое gpu в компьютере. Ничего о нем не знаете? Моя статья поможет вам избавиться от этого недоразумения;-).

Что такое CPU?

Что такое GPU

GPU имеет отличный от CPU характер рабочей нагрузки. Поэтому графические процессоры не используют модули предсказания переходов. Именно в этом и кроется ключ понимания различий между GPU и CPU.

Если центральный процессор необходим для выполнения различных задач, то видеокарта имеет строго определенное предназначение — рендеринг и обработка трехмерной графики. GPU намного быстрее и энергоэффективнее решает эти задачи. Однако графический процессор не столь гибок в своем диапазоне рабочих нагрузок.

Ядра видеокарты имеют один или несколько АЛУ, но в отличие от тех, что используются CPU они разработаны совершенно иначе. Они способны обрабатывать 8, 16 или 32 операции одновременно. Кроме того, ядра GPU могут состоять из десятков или сотен отдельных блоков АЛУ, благодаря чему графический процессор выполняет тысячи операций. Это особенно полезно во время обработки теней на дисплеях с высоким разрешением.

GPU это отдельное устройство компьютера или смартфона, разработанное для графического рендеринга и применяемое в качестве ускорителя трехмерной графики.

Из-за того, что GPU предназначен для обработки компьютерной графики, он рассчитан на массивные параллельные вычисления. Поэтому видеокарты имеют очевидное преимущество при больших объемах обрабатываемой информации.

По сравнению с центральными процессорами, графические имеют особую архитектуру, нацеленную на увеличение скорости расчета текстур и сложных графических объектов. Кроме того, у GPU более ограниченный набор команд.

Что касается тактовой частоты, то у GPU данный показатель, как правило, ниже чем у CPU. При это зачастую речь идет о сотнях МГц. Это обусловлено ограничениями тепла и мощности, поскольку для параллельной обработки массивных объемов данных требуется гораздо больше транзисторов.

Параллельные вычисления могут использоваться не только в качестве ускорителя трехмерной графики. С его помощью рендеринг видеороликов, разные алгоритмы криптографии и машинного обучения (вроде обнаружения объектов) будут работать намного быстрее на GPU, а не на CPU.

Аппаратные компоненты бортовой МПС унифицированного ударного истребителя F-35

Приоритеты современной военной авиации сосредоточены на качественной ситуационной осведомлённости, поэтому современный истребитель представляет собой летающий рой высокотехнологичных сенсоров. Сбор информации с этих сенсоров, её обработку и представление пользователю осуществляет бортовая микропроцессорная система (МПС). Вчера для её реализации использовались HPEC-гибриды (включающие в себя CPU, GPU и FPGA). Сегодня для её реализации используются однокристальные SoC-системы, которые помимо того, что все компоненты на один чипсет собирают, так ещё и внутричиповую сеть организуют (NoC), как альтернативу традиционной магистрали передачи данных. Завтра, когда SoC-системы станут ещё более зрелыми, ожидается приход полиморфной наноэлектроники, которая даст существенный прирост производительности и снизит темп своего морального устаревания.

Что такое GPU-ускорение на Android

Сама аббревиатура GPU на смартфонах расшифровывается точно так же, как и на других устройствах, включая компьютеры, и означает «Графический процессор». Поэтому при активации ускорения вся нагрузка телефона переходит с ЦПУ на видеокарту, едва ли задействованную в повседневных задачах.

Главное назначение GPU-ускорения заключается в принудительном переносе рендеринга с процессора устройства на GPU с целью повышения производительности. Как правило, особенно если брать в расчет современные мощные смартфоны или планшеты и весьма требовательные игры, подобная возможность положительно повлияет на скорость обработки информации. Кроме того, на некоторых телефонах можно получить доступ к дополнительным настройкам рендера.

Иногда ситуация может быть полностью противоположной, в связи с чем включение принудительного рендеринга двухмерного рисования может стать причиной невозможности запуска того или иного приложения. Так или иначе, функцию можно включать и отключать без ограничений, что делает большинство проблем легко разрешимыми. К тому же, как можно понять по вышесказанному, большинство приложений все же отлично работают при включенном GPU-ускорении, позволяя использовать ресурсы устройства на максимум.

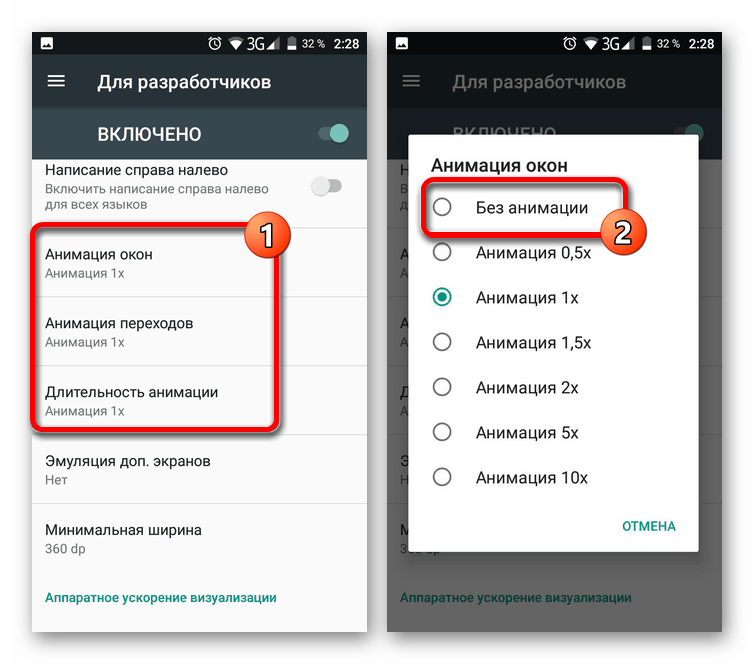

Включение и отключение

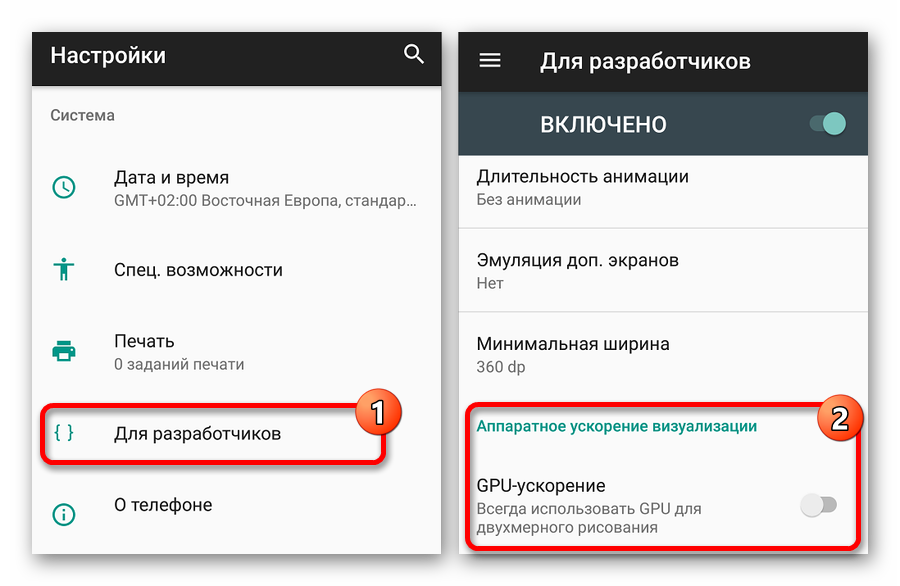

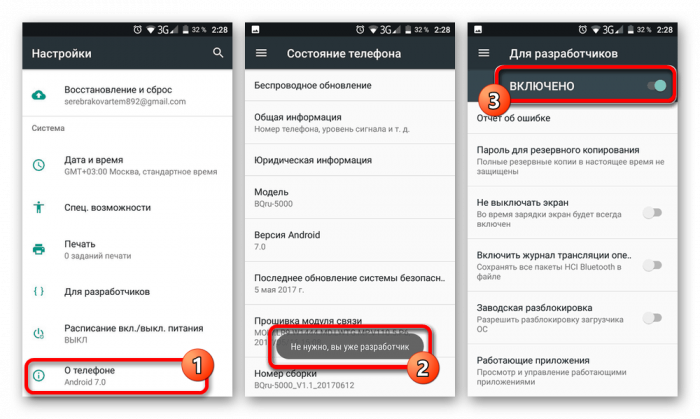

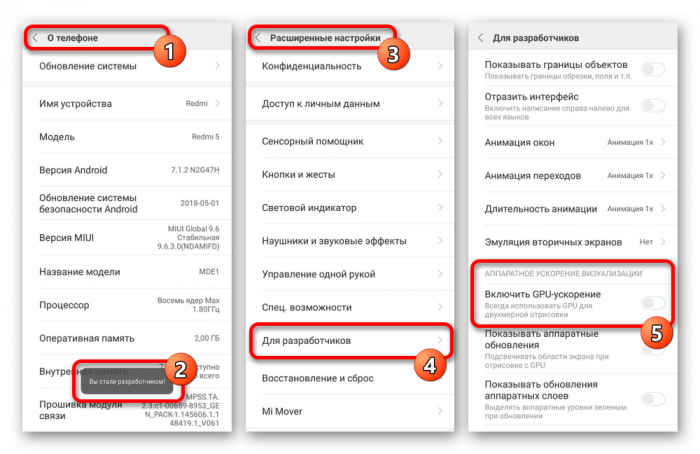

Подробнее: Как включить раздел «Для разработчиков» на Android

После перехода к странице «Для разработчиков» в системном приложении «Настройки» воспользуйтесь свайпом вверх и найдите пункт «GPU-ускорение» в блоке «Аппаратное ускорение визуализации». В некоторых случаях функция может иметь другое название, например, «Рендеринг принудительно», но практически всегда остается неизменным описание

Ориентируйтесь именно по нему, обратив внимание на представленный ниже скриншот

Эта процедура не станет проблемой, так как все действия легко обратимы. Таким образом, чтобы отключить принудительный рендеринг, деактивируйте пункт, указанный выше. Кроме того, данная тема напрямую связана с ускорением Android-устройства, детально рассмотренным нами также в отдельной инструкции.

Подробнее: Как ускорить телефон на платформе Android

Как видно из представленной в статье информации, GPU-ускорение на Android-устройствах можно включать и отключать в зависимости от конкретной ситуации, будь то запуск требовательных игр или приложений. С этим не должно возникнуть проблем из-за отсутствия ограничений на работу функции, не считая ситуаций, когда телефон по умолчанию не предоставляет нужных настроек.

Опишите, что у вас не получилось.

Наши специалисты постараются ответить максимально быстро.

Температура GPU

GPU является один из самых горячих компонентов компьютера. Как и центральный процессор, GPU выделяет много тепла и его нужно эффективно отводить. Иначе графический процессор начнет перегреваться, что приведет к снижению производительности, сбоям в работе, перегрузкам компьютера и даже поломке.

Если вы хотите проверить не только температуру GPU, но и температуры других компонентов компьютера, то для этого удобно пользоваться программой HWmonitor. Данная программа отображает температуру, частоты, загрузку и другие параметры сразу для всех компонентов.

После проверки температуры часто возникает вопрос, какую температуру можно считать нормальной. Точного ответа на этот вопрос нет, поскольку у разных GPU разный предел температур, которые они могут переносить без последствий. Но, в среднем нормальной температурой графического процессора является:

- до 55 °C в режиме простоя;

- до 80 °C под нагрузкой;

Если температура вашего GPU выходит за эти пределы, то это можно считать перегревом. В таком случае нужно улучшить охлаждение графического чипа, для того чтобы привести эти значения к норме.

Если нужно понизить температуру видеокарты, то стоит начать с удаления пыли, которая скопилась на ее радиаторе. Если радиатор сильно забит пылью, то это может повышать температуру графического процессора на 5-10 градусов. Если простая чистка радиатора не помогает, то нужно заменить термопасту. В крайнем случае можно улучшить продуваемость корпуса компьютера, добавив несколько вентиляторов на вдув и выдув воздуха.

Словарь

- GPU — Graphics processing unit, графический процессор

- Классификация Флинна

- SIMD — Single instruction multiple data, одиночный поток команд, множественный поток данных

- SIMT — Single instruction multiple threads, одиночный поток команд, множественные потоки

- Волна (wave) SIMD — поток, выполняемый в режиме SIMD

- Линия (lane) — отдельный поток данных в модели SIMD

- SMT — Simultaneous multi-threading, одновременная многопоточность (Intel Hyper-threading)[]

- IMT — Interleaved multi-threading, чередующаяся многопоточность[]

- BB — Basic Block, базовый блок — линейная последовательность инструкций с единственным переходом в конце

- ILP — Instruction Level Parallelism, параллелизм на уровне инструкций[]

- ISA — Instruction Set Architecture, архитектура набора команд/инструкций

- Ядро может называться CU, SM, EU

- Волна может называться фронтом волны (wavefront), аппаратным потоком (HW thread), warp, контекстом (context)

- Линия может называться программным потоком (SW thread)

Вариант для офисных задач и домашнего использования

Какие требования чаще всего вы выдвигаете к своему ПК? Если исключить игры, то получится следующий набор параметров:

- просмотр фильмов в HD-качестве и роликов на Youtube (FullHD и в редких случаях 4К);

- работа с браузером;

- прослушивание музыки;

- общение с друзьями или коллегами с помощью мессенджеров;

- разработка приложений;

- офисные задачи (Microsoft Office и похожие программы).

Все эти пункты прекрасно работают со встроенным графическим ядром на разрешениях вплоть до FullHD.

Выводы

На основании проведенного тестирования можно сделать следующие важные выводы. В современных видеоконвертерах действительно может применяться технология вычислений на GPU, что позволяет повысить скорость конвертирования. Однако это вовсе не означает, что все вычисления целиком переносятся на GPU и CPU остается незадействованным. Как показывает тестирование, при использовании технологии GPGPU центральный процессор остается загруженным, а значит, применение мощных, многоядерных центральных процессоров в системах, используемых для конвертирования видео, остается актуальным. Исключением из этого правила является технология AMD APP на графических процессорах AMD. Например, при использовании конвертера Xilisoft Video Converter Ultimate 7.7.2 с активированной технологией AMD APP нагрузка на CPU действительно снижается, но это приводит к тому, что время конвертирования не сокращается, а, наоборот, увеличивается.

Вообще, если говорить о конвертировании видео с дополнительным использованием графического процессора, то для решения этой задачи целесообразно применять видеокарты с графическими процессорами NVIDIA. Как показывает практика, только в этом случае можно добиться увеличения скорости конвертирования. Причем нужно помнить, что реальный прирост в скорости конвертирования зависит от очень многих факторов. Это входной и выходной форматы видео, и, конечно же, сам видеоконвертер. Конвертеры Xilisoft Video Converter Ultimate 7.7.2 и Wondershare Video Converter Ultimate 6.0.32 для этой задачи подходят плохо, а вот конвертер и Movavi Video Converter 10.2.1 способен очень эффективно использовать возможности NVIDIA GPU.

Что же касается видеокарт на графических процессорах AMD, то для задач видеоконвертирования их не стоит применять вообще. В лучшем случае никакого прироста в скорости конвертирования это не даст, а в худшем — можно получить ее снижение.

Обзор intel hd graphics 630

Обзор intel hd graphics 630 Как открыть слот для сим карты в телефоне

Как открыть слот для сим карты в телефоне

Процессоры amd fx

Процессоры amd fx

Что делать если телевизор не ловит цифровые тв-каналы: пошаговая инструкция

Что делать если телевизор не ловит цифровые тв-каналы: пошаговая инструкция Intel hd graphics 610 vs nvidia geforce gt 610

Intel hd graphics 610 vs nvidia geforce gt 610 Как снять блокировку на телевизоре

Как снять блокировку на телевизоре